Hier nun die finale Erinnerung für alle Geo-Interessierten: Heute ist Anmeldeschluss beim „Mitteldeutscher Geo-Treff 2018“ am 25./26.09.2018 in Halle (Saale).

Archiv der Kategorie: Allgemein/News

Geospatial Ready? Deutschland auf Platz 3!

Laut dem Geospatial Readiness Index-2018 finden wir Deutschland nach den USA und Großbritanien auf Platz 3.

„Der Einsatz dieser Lösungen beschränkt sich nicht nur auf traditionelle Sektoren wie Landwirtschaft, Bauwesen und Katastrophenmanagement, sondern findet auch in spezialisierten Sektoren wie Immobilien, Gebäudetechnik, Architektur, Bank- und Finanzdienstleistungen, Einzelhandel und Logistik, Forstwirtschaft und vielen anderen Anwendung. Es überrascht nicht, dass diese Volkswirtschaften entwickelt sind und in der Lage sind, ihre Position als Führer der Weltwirtschaft aufrechtzuerhalten, da sie die geografische Strategie offenbar in alle Arbeitsabläufe integrieren.“ [1]

(Übersetzt mit www.DeepL.com/Translator)

[1] … https://www.geospatialworld.net/article/worlds-geospatial-ready-countries/

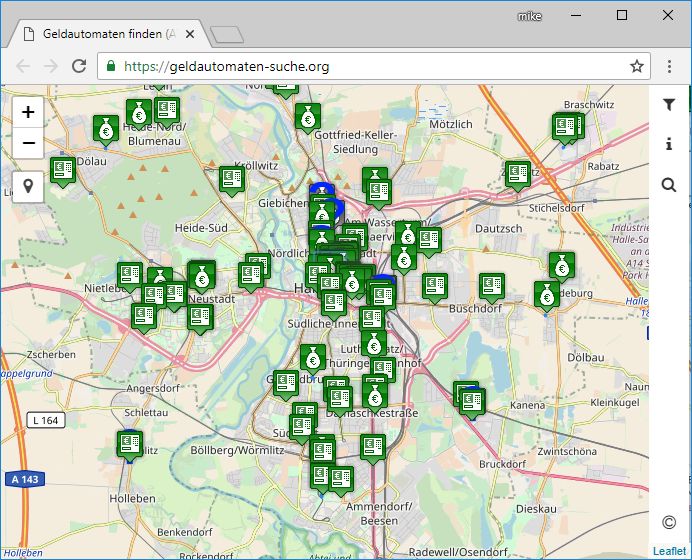

Geldautomat gesucht?

Eine neue Version von geldautomaten-suche.org ist lt. Marcus Bleil online verfügbar, jetzt mit verbesserter Anzeige für mobile Endgeräte. Inhaltlich können die Automaten der Sparkassen, Genossenschaftsbanken, CashPool und Cash Group sowie weiterer unterschieden werden, eine schnelle Adress-Suche ist integriert. Die Daten stammen aus dem OSM-Projekt.

Geldautomaten in Halle (Saale), Quelle: https://geldautomaten-suche.org/

Geldautomaten in Halle (Saale), Quelle: https://geldautomaten-suche.org/

Mitteldeutscher Geo-Treff 2018: Anmeldeschluß nicht verpassen!

Über den „Mitteldeutscher Geo-Treff 2018“ hab ich schon am 27.08.2018 informiert, heute die Erinnerung: ANMELDESCHLUSS ist der 19.09.2018, Ihr habt also noch genau sechs Tage Zeit. Also, los: A N M E L D E N !

OpenLayers v5.2 verfügbar

Ab sofort ist OpenLayers in der Version 5.2 auf GitHub verfügbar, siehe: https://github.com/openlayers/openlayers/releases/tag/v5.2.0

PgAdmin 4 v3.3 Released

Wie auf https://www.pgadmin.org/ zu lesen ist, hat das beliebte Admin-Tool für die PostgreSQL/PostGIS-Anwender und -Administratoren „PgAdmin“ ein neues Release erfahren. DIE Neuerung ist der Geometrie-Viewer, der PostGIS-Daten auf einer leeren Karte oder auf verschiedenen Kartenquellen darstellen kann.

Screenshots PgAdmin-Geometrie-Viewer (Quelle: Holger Naumann)

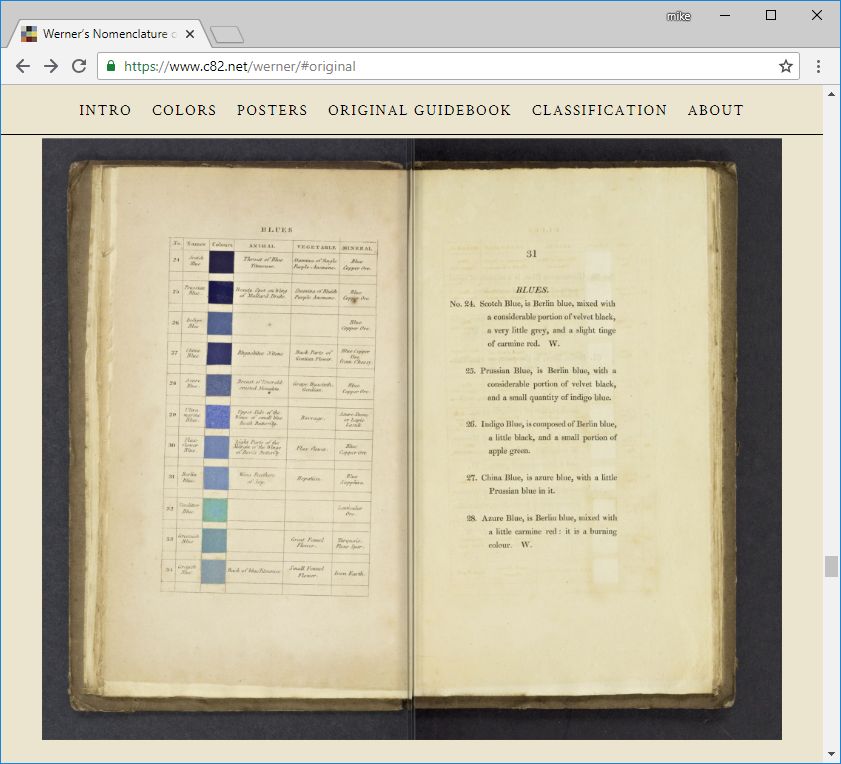

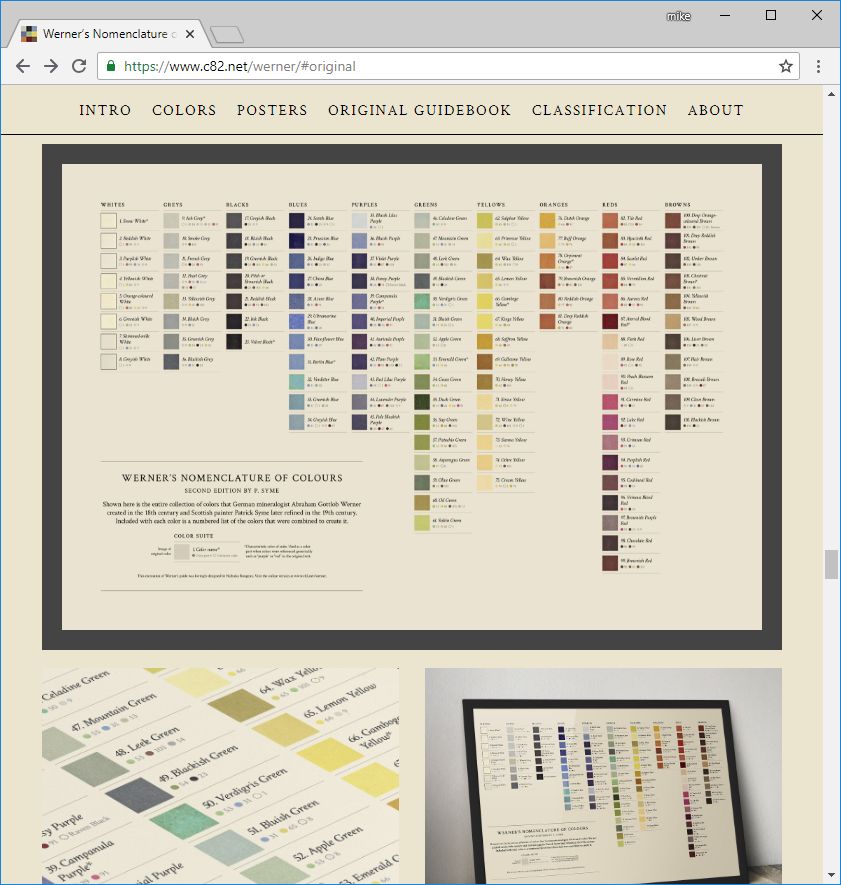

Werner’s wunderbare Welt der Farben

Im 19. Jahrhundert wurde ein standardisiertes Schema zur Klassifizierung von Farben „Werner’s Nomenclature of Colours“ durch Abraham Werner entwickelt, später von Patrick Syme weiter qualifiziert. Schon Charles Darwin nutzte es als Referenz auf seinen Reisen.

Original-Scan von „Werner’s Nomenklatur der Farben“

(Screenshot, Quelle: https://www.c82.net/werner/#original)

Nicholas Rougeux hat nun „Werner’s Nomenklatur der Farben“ online verfügbar gemacht und mit originalen Scans sowie neuen Beispiel-Fotos, Querverweisen und zwei neuen Plakaten nachgebaut.

Absolut sehenswert, einfach Genießen!!! https://www.c82.net/werner

Neu gestaltete Poster von Nicholas Rougeux

(Screenshot, Quelle: https://www.c82.net/werner/#posters)

EU-Urheberrechtsrichtlinie: OpenStreetMap in Gefahr?

Wenn es am Mittwoch erneut um auch den Artikel 13 der neu zu beschließenden EU-Urheberrechtsrichtlinie geht, sind freie Projekte in großer Gefahr. Die Prüfung, ob die eingestellten Inhalte dem Urheberrecht entsprechen, ist für solche Projekte nicht oder nur sehr langsam realisierbar. Um die Folgen aufzuzeigen, ist momentan jede zehnter Kachel auf https://www.openstreetmap.de/ schwarz. Mehr zu den Hintergründen findet Ihr auf https://www.openstreetmap.de/uf/index.html.

WICHTIG: Werdet aktiv, macht den EU-Parlamentariern klar, dass Ihr eine Abstimmung gegen diesen Artikel erwartet. #SaveYourInternet

Screenshots der Schwarzkacheln von OpenstreetMap.de

Screenshots der Schwarzkacheln von OpenstreetMap.de

Die versteckte Logik von Städten

In den letzten Wochen schien es in den einschlägigen Social-Media-Kanälen des GIS ein wichtiges Thema zu sein: Die versteckte Logik von Städten (…, Gebieten), also die Frage, wie sind die Flächen- oder Linienobjekte aggregiert über ihre Richtung pro Gebiet ausgerichtet, visualisiert als „Rosen-Diagramm“. Auf den ersten Blick erkennt man sofort die Unterschiede zwischen auf dem Reißbrett (?) entstandenen „Plan-Städten“ oder historisch gewachsenen Ortschaften.

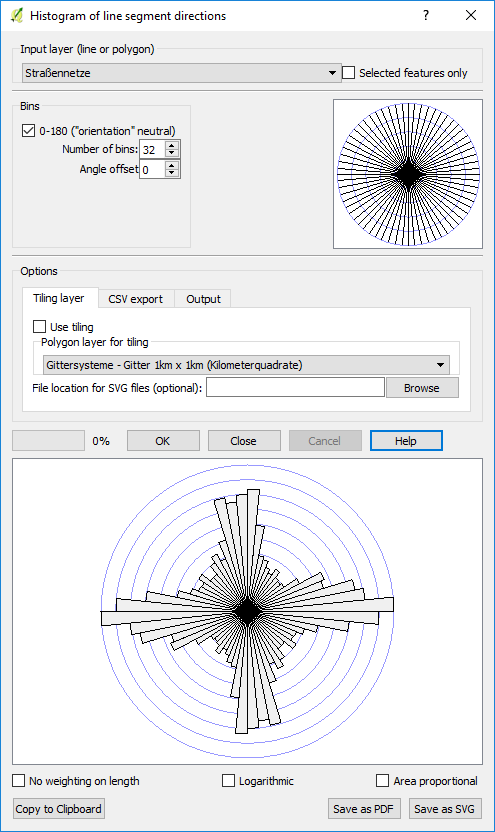

Ich hab mal versucht, es nachzuvollziehen, mit QGIS-Mitteln für Halle (Saale). Es klappt! Genutzt wurde die Erweiterung „The QGIS Line Direction Histogram Plugin“.

Rosen-Diagramme von Halle jeweils aggregiert pro Kilometerquadrat

Rosen-Diagramm für das Gesamt-Gebiet für Halle (Saale)

Mitteldeutscher GEO-Treff 2018

Der 10. Geofachtag Sachsen-Anhalt des netzwerk | GIS Sachsen-Anhalt findet in diesem Jahr als gemeinsamer „Mitteldeutscher GEO-Treff 2018“ mehrerer mitteldeutscher GIS-Vereinigungen am 25.-26. September 2018 in Halle (Saale) statt.

Hier nun der offizielle Einladungs-Flyer der Veranstaltung. Er kann gern genutzt werden, um für diese gemeinsame Veranstaltung zu werben. Nutzt Eure beruflichen Kanäle oder auch die sozialen Netzwerke. Wir haben ein attraktives Programm zusammengestellt. Auch in diesem Jahr ist die Teilnahme kostenlos.

Programm und Anmeldung findet Ihr unter www.mitteldeutscher-geotreff-2018.de. Die Online-Anmeldung ist bis zum 19.09.2018 freigeschaltet.

Wir freuen uns auf Euch, Eure Kollegen, Kunden und alle Interessierten!

Einladung_Md_GEOtreff_2018 (PDF, 2,8 MByte)